США должны сделать всё возможное, чтобы не допустить военного применения автономных боевых систем, пишет в статье для NBC News технический специалист Лиз О’Салливан. По её словам, Вашингтону следует сосредоточиться на обороне от подобных роботов-убийц, а не участвовать в потенциальной гонке вооружений с Китаем или Россией.

«Когда в начале этого года в Женеве я была на заседании комитета ООН, посвящённом системам смертельного автономного оружия (иначе говоря, роботам-убийцам), меня шокировало утверждение американских делегатов о том, что автоматическое оружие с искусственным интеллектом может быть безопасным и надёжным. Подобная мысль не только не соответствует действительности, но и угрожает всем нам. Точно такая же логика привела к холодной войне, ядерной гонке и созданию часов Судного дня», — пишет в статье для NBC News технический специалист Лиз О’Салливан.

Работая в одной молодой и развивающейся компании, автор статьи на собственном опыте убедилась в опасности «ненадёжных, но мощных технологий». О’Салливан опасалась, что может способствовать потенциальным планам Пентагона использовать искусственный интеллект в военных целях, и поэтому покинула отрасль. После этого она вступила в Международный комитет по контролю над роботизированными системами оружия (ICRAC) и присоединилась к кампании «Остановим боевых роботов», чтобы убедиться, что ИИ применяется ответственно, даже в случае вооружённого конфликта.

«Учитывая, что Россия активно стремится сорвать международные переговоры по регулированию систем смертельного автономного оружия (сокращённо LAWS), а Китай ставит на поток производство постоянно модернизирующихся беспилотников с ИИ, можно понять беспокойство относительно того, что две эти страны способны использовать роботов-убийц. Но лучший способ решить эту проблему для США — не стимулировать гонку вооружений и не строить собственные машины, которые будут больше, быстрее и смертоноснее. Лучший способ — не допустить эту гонку», — подчёркивает эксперт.

Она отмечает, что американцы уже следовали по пути обострения, и в этот раз им следует действовать умнее. Необходимо в рамках ООН принять международные законы, которые запретят разработку подобных систем и признают их применение недопустимым.

Если цель США — снизить напряжённость и добиться, чтобы Россия и Китай твёрдо соблюдали этот запрет, то им необходимо ограничить боевые преимущества этой технологии. В результате она станет менее привлекательной для противников и не будет стоить тех издержек, которые им придётся понести за нарушение международного соглашения, рассуждает автор статьи.

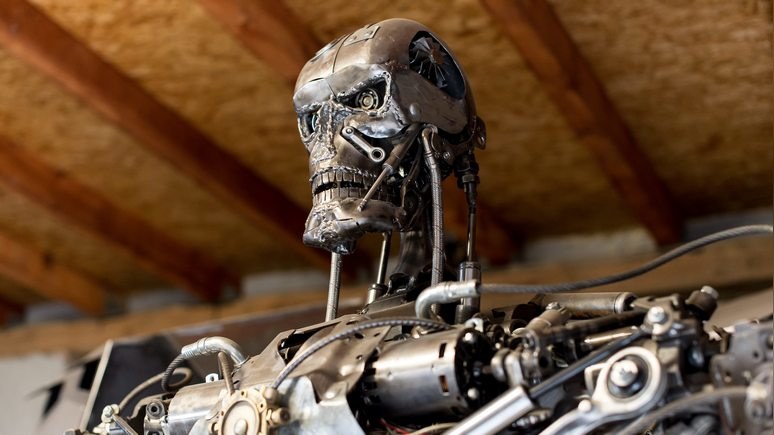

«Технические ограничения LAWS дают явную возможность держать крышку на этом ящике Пандоры закрытой. Мы должны задействовать наши значительные высокотехнологичные научно-исследовательские умы и ресурсы, чтобы разработать надёжные оборонительные, а не наступательные меры. Если наши враги строят терминаторов, мы можем сражаться, как Джон Коннор, который доблестно защищал человечество в восстании против его возможных повелителей — терминаторов», — полагает О’Салливан.

По её словам, модели ИИ могут оценивать только объекты, с которыми они встречались ранее, и учесть все сценарии невозможно. Угол камеры, свет, удалённость от объектов, качество съёмки и погодные условия — всего лишь несколько из множества факторов, которые могут сказаться на точности компьютерной модели, которая пытается определить цель.

«Вот что имеют в виду исследователи, когда называют такие модели «хрупкими»: они склонны трескаться, когда сталкиваются со сценарием, немного отличающимся от условий, введённых во время их построения. Это особенно верно в случае военных действий, поскольку ситуацию на поле битвы редко можно предсказать, и враг всегда будет пытаться найти способ использовать эту слабость», — обращает внимание технический специалист.

Пентагону необходимо будет обеспечить своих роботов-убийц компьютерным зрением, чтобы они могли находить цели. Но к настоящему моменту ни одна модель компьютерного зрения не способна противостоять так называемым состязательным атакам, призванным вводить ИИ в заблуждение.

Например, достаточно добавить немного цифрового шума на изображение, чтобы одолеть модель компьютерного зрения. Точно такой же эффект получится, если поместить танковый взвод под сеть из разноцветного блестящего конфетти или чего-то столь же неуместного. Если робот не обучен действовать в подобной ситуации, солдаты в этом камуфляже будут практически неуязвимы, утверждает О’Салливан.

Кроме того, исследования показывают, что не форма или цвет, а текстура позволяют моделям компьютерного зрения захватывать определённую цель перед атакой. Поэтому если терминатор ищет кожу, то от него можно скрыться в мехе. Если он запрограммирован действовать в пустыне, можно разместить на поле боя фиолетовый искусственный газон, считает автор статьи.

«Если мы хотим получить что-нибудь более высокотехнологичное, можно изобрести живой изменчивый камуфляж, который генерирует различные узоры и текстуры. Или вооружить наши войска неожиданными предметами, например, прикрепить к бронетехнике розовых надувных дикобразов. Поскольку эти объекты не похожи ни на что, использовавшееся для обучения алгоритму прицеливания, компьютер будет предполагать, что люди, которых он видит, каким-то образом отличаются от тех, кого его учили убивать», — предполагает О’Салливан.

Она признаётся, что не претендует на звание эксперта в области обороны, и предоставляет искать конкретное решение «Джонам Коннорам в разнообразных военных лабораториях США». Вместе с тем автор статьи со ссылкой на собственные знания предупреждает, что модели компьютерного зрения могут потерпеть фиаско.

«Утверждение американской делегации о целесообразности войны, при которой машины могут атаковать без вмешательства человека, продемонстрировало мне искреннюю нехватку технических знаний, необходимых для серьёзного ведения этих разговоров. Это главное, что пугает меня и остальных участников кампании «Остановим роботов-убийц». Системы смертельного автономного оружия по своей природе небезопасны, и если мы позволим странам, особенно недемократическим, создать их, мы все проиграем от их ошибок», — заключает Лиз О’Салливан.